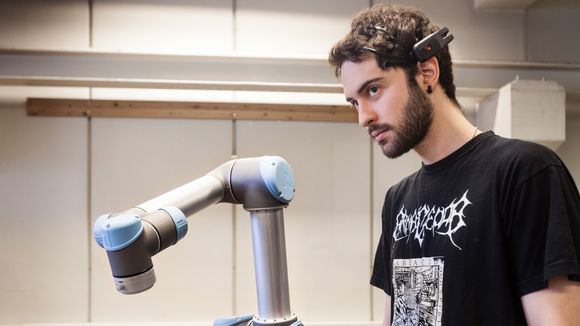

– Jeg bruker ansiktsbevegelser, for eksempel øynene og øyenbrynene. Med brynene velger jeg hvilke ledd på roboten som skal bevege seg, smiler Angel, som er masterstudent på NTNU.

Les også: Roboter kan redde norsk industri

EEG

Ansiktsgrimasene gir nemlig store utslag i elektrisk aktivitet langs hodet (EEG-signaler). Det samme skjer om Angel konsentrerer seg om et symbol på en dataskjerm, som blinkende lys.

I begge tilfellene leser elektrodene av aktiviteten i hjernen, og signalene blir deretter tolket av en prosessor som igjen gir beskjed til roboten om å bevege seg på en forhåndsbestemt måte.

–Jeg kan fokusere på ulike lys på skjermen, og robotbevegelsen avhenger av hvilket lys jeg velger og hvilken aktivitet dette skaper i hjernen, sier Angel.

– Ideen om å kontrollere en robot kun ved hjelp av tankekraft, eller aktivitet i hjernebølgene, er fascinerende og futuristisk.

Les også: Styr dataspill med hjernen

Robotskole

Angel Garcia er ikke alene om å klekke ut nye måter å manøvrere roboter på. I kybernetikkmiljøet på NTNU/SINTEF hersker det ren undervisningsstemning om dagen.

I robothallen er medstudent Signe Moe i ferd med å guide sin robot med armbevegelser, mens SINTEF-forsker og veileder Ingrid Schjølberg forsøker å få sin robot med tre fingre, til å gripe objekter på nye måter via et nytt læringsprogram.

– Hvorfor denne opplæringsiveren?

– Vel, alle kjenner til industriroboter ved samlebåndet som jobber med å plukke opp, eller sette sammen deler. De er forhåndsprogrammerte og lite fleksible. Med spesialgripere som er tilpasset de enkelte objektene, gjør de den samme manøver gang på gang, forklarer Ingrid Schjølberg.

– Så dere lager noe nytt?

–Vi ser at industrien får store problemer om nye deler blir introdusert og skal gripes på samlebåndet. Da blir det komplisert å bytte griper og styreprogram for roboten. Dette vil vi forenkle. Vi ønsker også at roboter skal kunne programmeres mer intuitivt og ikke bare på tradisjonell måte via et panel med knapper som man trykker på.

Les også: Super-roboten får nye krefter

"Vi ønsker du skal flytte deg hit"

Oppgaven til Signe Moe har derfor vært å finne ut hvordan menneskelige bevegelser kan gjenspeiles i roboten. Dette har hun løst gjennom et system der hun guider roboten via et Kinect-kamera som benyttes i spillteknologi.

– Hvem som helst kan nå egentlig styre roboten. Forleden var elever fra en 6.klasse innom robothallen. De styrte roboten uten vansker fordi de er vante med dataspill, forteller Signe.

Hun stiller seg halvannen meter foran kameraet og demonstrerer:

– Jeg starter med å holde opp høyrehanda og foreta et klikk i lufta som gjør at kameraet registrerer meg og sporer handa mi. Når jeg nå beveger handa mi opp i lufta og til høyre, ser du at roboten speiler bevegelsen.

–Det ser enkelt ut, men hva skjer…?

– Kinect-kameraet har ferdige algoritmer som kan spore hendene mine. Alt vi må gjøre er å regne disse dataene om til posisjonen vi ønsker for roboten, og sette opp et kommunikasjonssystem mellom sensoren i kamera og robot. Roboten får da inn en referanse ala "vi ønsker du skal flytte deg hit", og en innebygd regulator regner så ut hvordan den skal komme seg dit og hvor mye strøm som må settes på motorene for å sørge for en slik forflytning.

Les også: Med denne kan du styre nesten hva som helst - med hånda

Ny læring via kamerabilder og sensorer

Ingrid Schjølberg viser oss robotgriperen med tre fingre. Å lære en robot nye måter å gripe på, vil være nyttig for industrien. Derfor tester forskerkollegene nye metoder.

– Vi kombinerer sensorer i robothanda med bilder fra et Kinect-kamera som identifiserer delen som skal fanges. Roboten kan da lære seg selv hvordan det er lurt å gripe på nye måter. Den prøver ut ulike grep slik vi mennesker gjør når vi skal gripe en ukjent ting. På forhånd har vi satt opp noen kriterier for hva som er et bra og dårlig grep. Roboten tester flere grep, og gjennom en poengsum får den skryt eller skjenn som respons, smiler Schjølberg.

– Er denne metoden satt ut i livet?

– Dette systemet er ikke industrialisert, men vi har det oppe og går her i hallen vår. Neste steg kan bli å installere roboten hos en av industriaktørene som deltar i prosjektet.

Prosjektet Next Generation Robotics for Norwegian Industry favner nemlig om alle delaktivitetene som bedrives, og her er industripartnere som Statoil, Hydro, Glen Dimplex og Haag med.

– De finansierer arbeidet, men er også involvert gjennom caser og problemstillinger. I tiden som gjenstår av prosjektperioden, skal vi arbeide med å lage softwaren og systemet mer robust.

Denne saken ble opprinnelig publisert på Gemini.no – et nettsted for forskningsnytt fra NTNU og Sintef. Artikkelforfatteren er tilknyttet Sintef.

Flere nyheter fra gemini.no: