Da CDN-teknologien utviklet seg i siste halvdel av 90-tallet, var det fordi det begynte å bli vanskelig å flytte all trafikken som skulle fra kildeserveren til alle internettklientene.

Av og til skulle filene flytte seg langt, på linjer med mindre kapasitet. Og ofte i mange steg fra ruter til ruter. Mange filer ble etterspurt samtidig av mange flere enn serverne, hvor filene lå, kunne levere til raskt nok.

Les også: Her kommer fremtidens servere

Begynte å mellomlagre

Løsningen var ganske lik den man finner i enhver pc.

Uten smart teknologi som mellomlagrer all slags informasjon som er mye etterspurt, ville det oppstått flaskehalser og leveringsproblemer på nettet.

Løsning: Flytt det mest etterspurte innholdet nær konsumenten.

I en pc er det prosessoren, på nettet er det klientene som er konsumenter. I pc-en kaller vi det caching. Det går fantastisk mye raskere om data og instruksjoner ligger i ram enn på harddisken, og enda raskere om det ligger på cachlageret i selve prosessoren.

Les også: Verdens raskeste datamaskin

Som et vanntårn

På samme måte er det på nettet. Jo nærmere, desto bedre.

Men her sprer man innholdet på en mengde CDN-servere rundt om i internettet, for det er ikke én som etterspør, men svært mange.

I stedet for at all informasjon skal leveres fra selve kilden og utover i nettverket, blir mye etterspurt informasjon mellomlagret lenger ut i nettet.

Et CDN er altså en masse distribuerte servere som står mye nærmere klientene enn selve kilden.

Et typisk eksempel: Når en film eller en nettside er mye etterspurt, kopieres den fra kilden til en CDN-server nærmere konsumentene. Når folk vil se filmen, eller hente websiden, blir forespørselen rutet til CDN-serveren som står for leveringen.

Noen har sammenliknet CDN med vanntårn hvor vannet pumpes opp for å kunne holde det lokale trykket oppe når forbruket er høyt. En annen analogi er at trafikken blir mer som kringkasting i stedet for en telefonsamtale.

Les også: IBM satser på norske Numascale

Tidsskille

Det var selskapet Akamai som startet med CDN i 1998. I dag er de giganten med over 100 000 servere over hele verden og noen hundre i Norge.

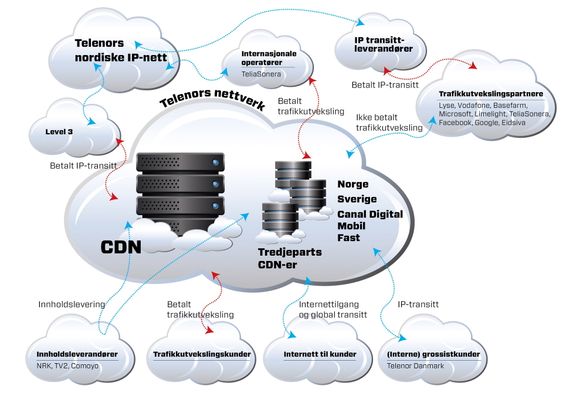

Telenor etablerte sitt eget CDN året etter, samtidig som de selger hosting og båndbredde til CDN-servere i sine datasentre for andre selskaper.

I starten var det snakk om å lagre etterspurte nettsider, og det gjør man ennå. Når du bestiller flybilletter på nettet, er det mest sannsynlig en CDN-server du snakker med. Ellers ville det blitt for tregt. Hadde det ikke vært for at Limelight brukte spesiell CDN-teknologi for dataspillere, ville opplevelsen blitt mye dårligere.

Det finnes ulike typer CDN som spesialiserer seg på ulike tjenesteformer som nettskytjenester, mobile terminaler osv.

Under OL i London sendte NRK og en masse sportskanaler direkte fra de ulike øvelsene. Live tv er vesentlig mer krevende enn opptak. Det kunne de ikke ha levert fra studio i London til alle seerne, derfor gikk de via et CDN som tok grovjobben.

Det gikk altså en IP-strøm fra London til Norge, deretter mange IP-strømmer fra de norske CDN-serverne til de norske seerne.

Les også:

Færre aktører

Det blir stadig færre aktører som står for de store trafikkvolumene på nettet.

For fem, seks år siden formidlet rundt 10 000 ISP-er halvparten av trafikken på nettet. I dag tar færre enn 100 veldig store aktører den samme prosenten, som nå også representerer et enormt mye større volum.

Noen av de store aktørene som Google og Netflix driver sine egne CDN. Andre selger tjenester til selskaper som trenger gode kundeopplevelser. Limelight, Akamai og Telenor er blant slike.

En del av de aller største nettoperatørene som AT&T og Level 3 har også sine egne CDN for å avlaste sine egne nett.

Les også: Bare USA har hatt internett lenger enn Norge

Servere

Den viktige komponenten i et CDN er serverne som er distribuert ute i ulike datasentere i nettet. Dette er ikke annet enn vanlige Linuxservere med mye minne og en webserver på toppen.

Svært ofte er det norskutviklede Varnish som benyttes. En typisk CDN-server har 48 GB ram og svært høy I/O-kapasitet.

Det mest etterspurte innholdet flyttes fra disk til ram. Siden ram er dyrt og disk er billig, bruker man begrepet «time to live» som et sentralt begrep. Det er tiden innholdet lever i ram.

Når etterspørselen synker, flyttes innholdet tilbake til disk hvor det kan bli lenge – avhengig av avtaler og etterspørsel. Er det ingen etterspørsel på en stund, vil innholdet bli slettet fra disk, og da vil eventuelle forespørsler måtte formidles fra kilden igjen.

I Telenors CDN er det rundt 100 servere. Noen har jobben med å hente inn innhold, mens andre spiller det ut til kundene.

Les også: Dette risikerer du ved å lagre filer i nettskyen

Planlegges

Driften av CDN er blitt svært viktig for nettopplevelsen til folk, og Telenor planlegger ut fra belastningstopper som de vet kommer.

Pågår et stort sportsarrangement, har de mest mulig kapasitet tilgjengelig.

De store innholdsleverandørene, slik som NRK og TV2, har også CDN-avtaler med flere, og kan lastbalansere mellom dem.

Les også:

Se Googles hemmelige datasentre

Dette endrer hele IT-landskapet