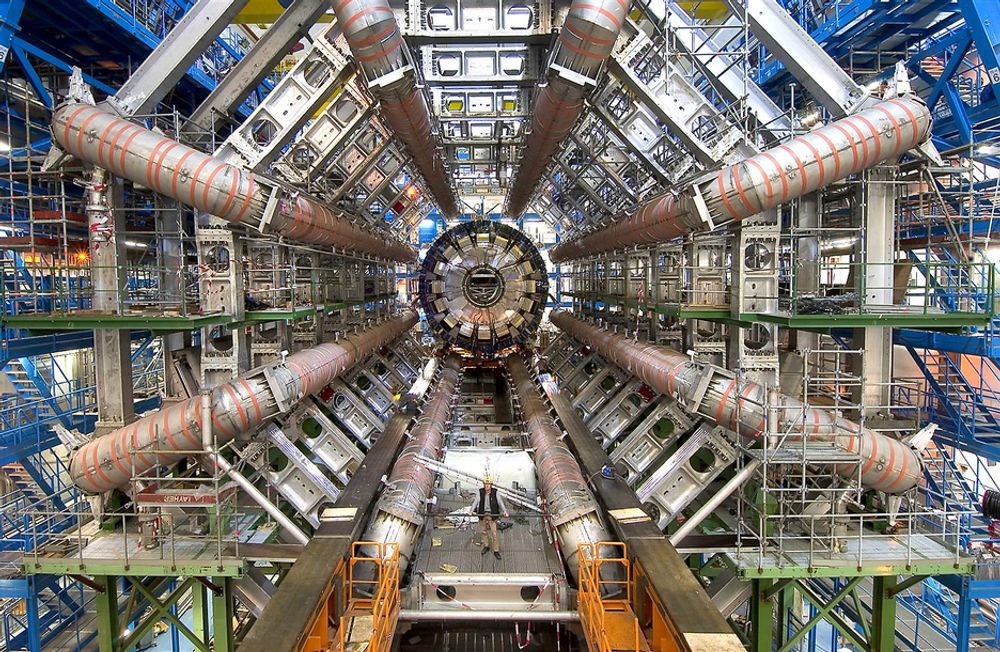

Neste år åpnes den nye gigantiske partikkelakseleratoren på Cern som skal gi oss ny fundamental kunnskap om fysikk.

Den skal kunne akselerere partikler som i kollisjonsøyeblikket kan gjenskape tilstanden slik universet var et 10 i minus trettende sekund etter Big Bang.

Strømkrevende

Inne i akseleratoren sitter det millioner av sensorer for hvert av de fire hovedeksperimentene og de kommer til å generere enorme datamengder når forsøkene starer opp.

Det er beregnet at det vil genereres 10 PB - Petabyte eller 10 000 TB - Terabyte hvert år som skal lagres og bearbeides av 100 000 prosessorkjerner i første omgang. Det er så mye at det ikke er nok strøm i Cernområdet både til å drive akseleratoren og til å arbeide med dataene.

Fordeler data

Løsningen er å lagre data distribuert på 10 hovedlagre rundt om i verden. De samme dataene vil lagres rundt tre ganger, derfor trengs det årlig 30 PB lagerplass.

Et av lagrene er det såkalte "Tier 1", som igjen er fordelt på fire land i Norden. Universitetet i Oslo er allerede i gang med sitt lager, som snart vil være på 200 TB. I tillegg kommer et lager på Universitetet i Bergen.

Det er HP som har fått den første delen av lageret i Oslo, et lager som vil vokse kraftig i årene fremover for å holde tritt med dataene som strømmer inn på den nye 10 Gbit/s-linjen mot Europa.