Hukommelse

For å få beregningen til å gå så fort som mulig er det viktig at prosessornodene har effektiv tilgang til minnet. Det er mange måter å designe minnetilgangen på, enten ved at hver node har sin egen hukommelse eller at de arbeider mot et delt minne, gjerne via individuelle bufferlagre. Minnemoduler kan også være koblet til prosessorene via svitsjer som kobler riktig minne til den aktuelle prosessor som etterspør eller skal lese ut informasjonen svært raskt.

Grid

En spesiell måte å hente ut svært høy ytelse på er å koble vanlige datamaskiner som PC-er til hverandre over lokalnett eller internett og la dem samarbeide om å løse komplekse oppgaver. De aller fleste PC-er bruker bare en liten brøkdel av den datakraften de har. Stadig bedre programvare for å fordele oppgaver over nettet kan gi enkel tilgang til høy ytelse for en billig penge. Det er mulig å donere sin egen PCs ledige datakraft over nettet og bidra til alt fra hjerteforskning til å finne signaler fra liv på fremmede planeter.

Superdatamaskin, High Performance Computing (HPC), tungregning. Kjært barn har mange navn.

De siste ti årene har de flyttet seg fra forskningen ut i industrien.

Superdatamaskiner brukes først og fremst i vitenskapelige og tekniske beregninger og spesielt når de skal håndtere enorme databaser og store beregningsoppgaver.

I Norge har vi flere, spesielt innen oljeindustrien og på universitetene. De regner på alt fra værmeldinger, tredimensjonale seismiske data, og folding av proteiner til krasjtesting av kjøretøyer og simulering av atombomber. I dag er betegnelsen superdatamaskin kanskje litt misvisende siden de aller fleste slike installasjoner i virkeligheten er store mengder servere koblet sammen i parallell med spesiell maskin- og programvare

Vektorprosessorer

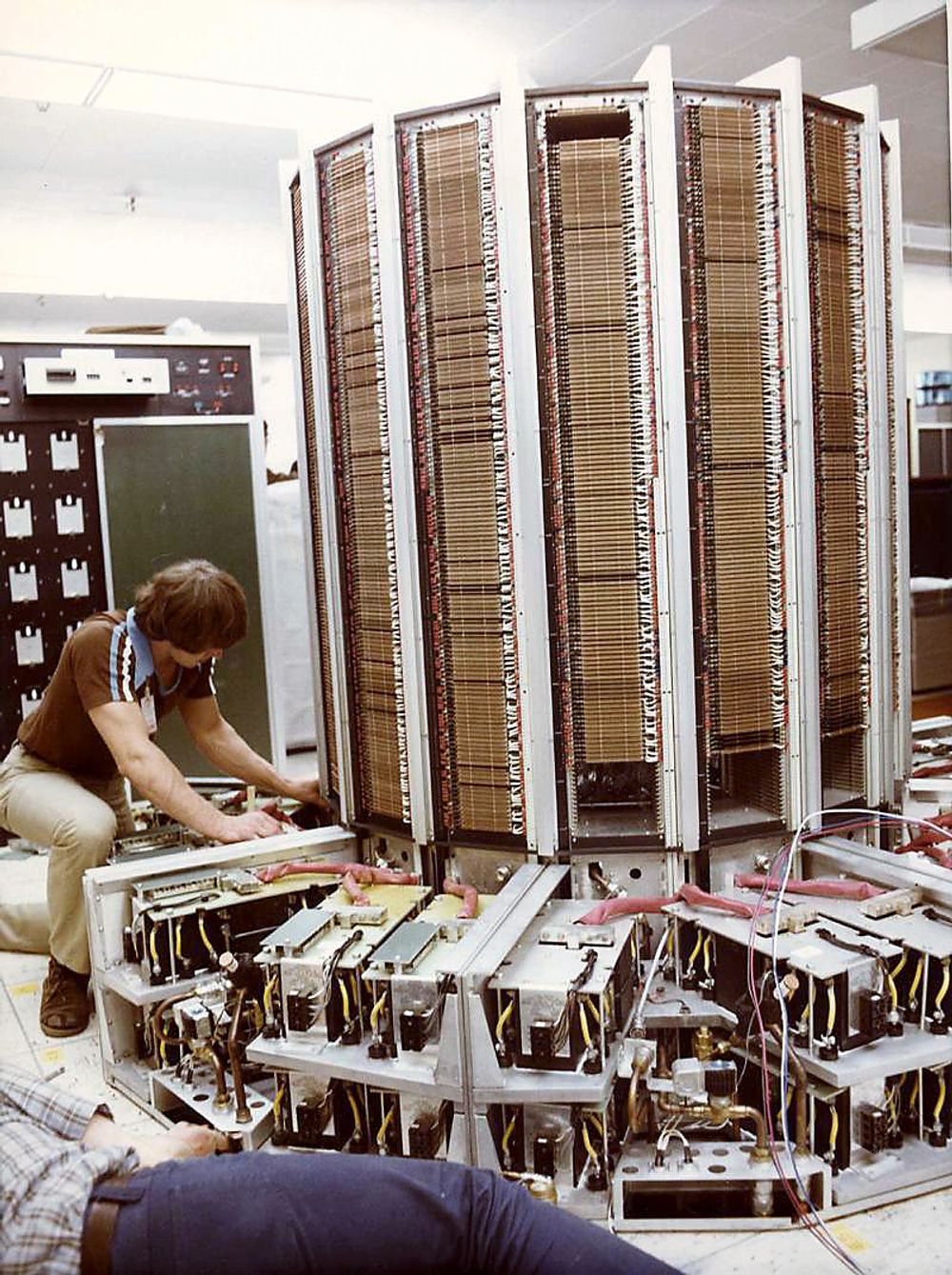

Ingen maskin forbindes mer med superdatakraft enn Cray. Cray X-MP, som i sin tid sto på Sintef i Trondheim, og nå er stedt til hvile på Teknisk Museum, var et regnemonster som i sin tid fikk det til å funkle i øynene på forskerne. Men akk, tidens tann har tært spesifikasjonene sønder og sammen og de fleste laptop-er på Elkjøp kan kjøre ringer rundt Cray-en i dag.

Såkalte vektorprosessorer ble først brukt i superdatamaskiner, og var en viktig grunn til at de var mye raskere enn vanlige datamaskiner på 80-tallet. Vektorprosessorer kunne utføre matematiske beregninger på mange dataelementer samtidig. På 90-tallet ble vanlige prosessorer utstyrt med slike vektorenheter, slik som SIMD (Single Instruction Multiple Data) hos Intel. som øker hastigheten på blant annet multimedieinnhold.

I dag dominerer IBM superdatafeltet, og Store Blå lager de fleste av de raskeste maskinene i verden. Men det er vanskelig å sammenlikne tidligere superdatamaskiner med dagens modeller. De er bygget på en helt annen måte. IBM kaller slik databehandling for deep computing.

De fleste husker da maskinen Deep Blue i 1997 slo verdensmesteren i sjakk, Garry Kasparov. Senere modeller har fått navnet Blue Gene fordi de har blitt brukt til å beregne folding av proteiner, en enormt beregningsintensiv oppgave.

Raskest

Den klassiske superdatamaskinen Cray X-MP hadde en klokkefrekvens på utrolige 105 MHz da den ble lansert i 1982. IBMs PC, som kom året før, hadde til sammenlikning 2,8 MHz. Den «enorme» klokkefrekvensen var med å gi X-MP-en en ytelse på hele 200 megaflops. Slike maskiner regner med flyttall i stedet for heltall. Ved å bruke flyttall er det mulig å representere svært store tall i datamaskinen med stor letthet og følgelig regne mye raskere.

Den raskeste datamaskinen i verden i dag er IBMs snart to år gamle BlueGene/L med en toppytelse på 367 Teraflops. Den har 131 072 prosessorer og 32 768 GB hovedminne. Neste år vil den bli forbikjørt av IBMs enda suprere maskin som for første gang bryter gjennom en Petaflop i ytelse, altså tusen milliarder milliarder flyttallsoperasjoner i sekundet!

I 2011 mener IBM at den første maskinen på 10 Teraflops vil være klar.

Kaldere

Energibehovet er superdatakraftens verste fiende. Tusenvis av prosessorer, disker og andre komponenter har kjempeappetitt på strøm. Løsningen for superdatamaskiner er paradoksalt nok svakere og mindre energikrevende prosessorer. Men langt flere av dem.

.png)

.jpg)

Rekordmaskinen BlueGene/L har et kraftbehov på 1,7 MW, men IBM tror det vil være mulig å redusere kraftbehovet for å nå Petaflop-en til rundt 2 MW og ti ganger dette til godt under 20 MW. Hvis like maskiner skulle ha vært bygget med x86-prosessorer, ville den samme ytelsen kreve sju til åtte ganger mer energi.

Parallelle

På en måte kan utviklingen innen superdatamaskiner sammenliknes med det som har skjedd i vanlige PC-er. For et par år siden gikk det opp for Intel at det ikke ville være mulig å få prosessorene til å snurre fortere uten at strømforbruket ville bli uakseptabelt høyt. Til slutt ville prosessorkjernene smelte. Løsningen ble å fordele lasten på to kjerner, og nå kommer modeller med fire og åtte er i sikte.

Det samme har skjedd innen HPC, men her snakker vi ikke om prosessorer, men om noder. Og de nodene er ikke så spesielle som man skulle tro. De fleste er helt vanlige servernoder. Det er måten de jobber sammen om felles regneoppgaver på som gjør at de til sammen gir så høy ytelse. I 1993 introduserte IBM den typen parallellisering av servernoder som er vanlig i dag og som bygges av de fleste store maskinvareleverandørene. En spesiell programvare sørger for å dele opp beregningsoppgavene og fordele dem på de tilgjengelige nodene i regneklyngen.

Måten nodene snakker sammen på, såkalt interconnect, er selvfølgelig svært viktig for ytelsen. Gigabit Ethernet dominerer som sammenkoblingsteknologi. Det er også utviklet interconnect-teknologier med høy bitrate som InfinBand. Selv om denne teknologien er tregere enn neste generasjon 10 Gigabit Ethernet, har den raskere svartider (latency) og spås en viktig rolle i fremtidens maskiner. Norske Scali, som har røtter tilbake til Norsk Data, har utviklet programvare for å få servernodene til å snakke effektivt med hverandre.

Mens andre typer datamaskiner masseproduseres, bygges de aller fleste superdatamaskiner en av gangen etter spesifikasjoner. I dag finnes det flere varianter av parallellmaskiner avhengig av behov. Noen er hybridmaskiner med flere typer prosessorer som kan flytte lasten rundt avhengig av oppgaven.

I dag er parallellmaskiner helt dominerende godt hjulpet av Linux operativsystem og programvare basert på åpen kildekode. Nå har Microsoft også meldt seg på og utvikler en spesiell versjon av Windows for superdatamaskiner.